Il modello-insegnante della Fondazione Agnelli

di Giovanni Carosotti and Rossella Latempa da roars.it

A metà giugno, la Fondazione Gianni Agnelli (FGA) ha reso pubblici i risultati di uno studio dal titolo Osservazioni in classe: come si sviluppano le competenze didattiche in Italia. rappresenta «la prima indagine condotta in Italia che riguardi l’osservazione diretta delle pratiche didattiche di oltre 1600 insegnanti di italiano e matematica». I dati parziali resi pubblici sono così macroscopicamente, definitivamente negativi, che non possono non indurre a una riflessione. L’intento di questo documento è provare a mostrare, una volta di più, che non sempre, quando si parla di educazione, di scuola o di università, tabelle e dati statistici rendono ragione dei fenomeni osservati. Nel caso specifico i dati proposti, tutt’altro che neutri, intendono suffragare una particolare visione della scuola, strettamente condizionata dal mondo della produttività e dell’economia. I risultati della FGA non “raccontano” il fallimento dell’insegnamento. O almeno, non lo raccontano a chi ha voglia di capire e approfondire linguaggi, metodi e contesti.

Premessa

A metà giugno, la Fondazione Gianni Agnelli (FGA) ha reso pubblici i risultati di uno studio dal titolo Osservazioni in classe: come si sviluppano le competenze didattiche in Italia. Si tratta di alcune anticipazioni degli esiti di un progetto sperimentale condotto in collaborazione con l’INVALSI, nell’anno 2013-2014, ancora in via di completamento[1]. Il progetto, scrive FGA, rappresenta «la prima indagine condotta in Italia che riguardi l’osservazione diretta delle pratiche didattiche di oltre 1600 insegnanti di italiano e matematica», nelle classi di V primaria e I secondaria di I grado. Il sommario pubblicato è un breve allegato di 6 pagine, contenenti dati su un campione di scuole omogeneamente distribuito tra nord, centro e sud. Le aree indagate sono 4, considerate centrali nella relazione educativa: il clima in classe, l’attività e il dialogo, l’attenzione alla diversità, il feedback sul lavoro da svolgere.

Dai risultati parziali appena pubblicati emerge un quadro sconfortante sotto ogni aspetto:

il clima in classe si deteriora progressivamente dalla scuola elementare alla media;

circa la metà degli insegnanti non dedica spazio alla discussione né svolge attività strutturate, lavora senza presentare obiettivi e senza chiarezza;

l’80% degli insegnanti non svolge adeguata differenziazione dell’attività, proponendo compiti uguali per tutti gli studenti indipendentemente dalla loro difficoltà specifiche;

nonostante sia cosa nota che l’attenzione al lavoro degli studenti è fondamentale per il loro apprendimento, circa la metà degli insegnanti non vi dedica cura: solo il 20% lo fa in maniera “adeguata”.

I dati sono così macroscopicamente, definitivamente negativi, che non possono non indurre a una riflessione.

L’intento di questo documento è provare a mostrare, una volta di più, che non sempre, quando si parla di educazione, di scuola o di università, tabelle e dati statistici rendono ragione dei fenomeni osservati. Nel caso specifico i dati proposti, tutt’altro che neutri, intendono suffragare una particolare visione della scuola, strettamente condizionata dal mondo della produttività e dell’economia. I risultati della FGA non “raccontano” il fallimento dell’insegnamento. O almeno, non lo raccontano a chi ha voglia di capire e approfondire linguaggi, metodi e contesti.

Da dove partire?

Crediamo che la maggior parte di noi, chi da insegnante, chi da alunno, da genitore o semplice cittadino, abbia una percezione della Scuola (pubblica) che, lungi dall’essere virtuosa, non sembra corrispondere nei numeri, ai dati pubblicati dalla Fondazione Agnelli. Nel mini-rapporto si sente l’eco del documento della Buona Scuola del 2014[2], che la FGA con quest’indagine si propone chiaramente di sostenere, accettandone sia i discutibili parametri, sia le altrettanto discutibili finalità formative; in particolare, l’idea che niente della nostra Scuola si debba sostanzialmente salvare. Finalmente quei «docenti generici»[3], che si accontentano della sopravvivenza nella loro «comfort zone»[4], possono essere smascherati e messi nell’angolo, risultati numerici alla mano. L’insegnante medio è proteso sommariamente (in modo non strutturato) alla trasmissione di nozioni, non si cura dei bisogni individuali dei bambini, che in alcuni casi devono chiedere il permesso per intervenire, e non “fa didattica innovativa”[5]. Una tale demolizione della figura dell’insegnante coincide con la demolizione della Scuola stessa. Nessuno vuole negare che esistano insegnanti più o meno capaci, ma è possibile che l’80% degli insegnanti non tenga conto dei bisogni differenziati degli alunni? Che metà degli insegnanti non dialoghi in classe? Che sempre la metà non dia adeguate spiegazioni su cosa fare? E tutto questo, durante l’«osservazione in classe delle sue competenze didattiche»? Per rispondere, è necessario un piccolo approfondimento, che permetta di decodificare queste percentuali grezze e senza scampo. I dati numerici hanno sempre una storia. Sono l’esito di scelte e decisioni operate a monte e non l’output di un algoritmo puro e inconfutabile.

Quest’assunto sembrerebbe in realtà condiviso dalla stessa FGA. Nell’ l’incipit del Rapporto sulla valutazione delle scuole della Fondazione Agnelli del 2014, è possibile leggere: «Non esiste in astratto il «giusto» modello della valutazione: ciascun modello dipende da un’idea di scuola. Si valuta che cosa si ritiene importante (ad es. gli apprendimenti). La misurazione serve in quanto strumento di valutazione»[6]. Nel caso del documento in oggetto, i procedimenti di valutazione utilizzati presuppongono un’idea di istruzione identica a quella promossa dalla Buona Scuola. Il che attribuisce al documento non l’obiettività di una ricerca condotta secondo criteri di neutralità, bensì i caratteri di una presa di posizione politico-ideologica.

“Osservazione in classe” – la metodologia utilizzata

Nel programma in questione la valutazione esterna precede quella interna (autovalutazione). La particolarità del progetto consiste nella fase di osservazione in classe che “non ha finalità valutative, ma meramente conoscitive”[7].

Ancora: «L’osservazione in classe viene effettuata da due osservatori formati nell’ambito delle scienze pedagogiche e sociali e con esperienze di lavoro e ricerca in ambito universitario». Come di consueto, il giudizio sull’attività didattica dei docenti viene affidato a professionisti estranei alla scuola e non competenti né dell’ambito disciplinare esaminato, né della didattica relativa alle discipline prese in esame (in questo caso italiano e matematica). Come vedremo, quest’apparente paradosso è in realtà voluto, in quanto il principio alla base della nuova scuola è proprio quello della svalorizzazione del sapere disciplinare, a favore di una metodologia della trasmissione didattica che non è finalizzata all’acquisizione di contenuti specifici, bensì di alcune abilità astratte, meglio misurabili grazie al contributo ritenuto più affidabile di particolari scienze sociali.

«La tecnica di osservazione utilizzata non è invasiva: gli osservatori si posizionano all’interno della classe in modo da non arrecare disturbo all’attività didattica e non intervengono in alcun modo nel corso della lezione […]. La checklist di osservazione serve a registrare la frequenza, in termini di presenza o assenza, delle azioni indicate, ad intervalli di 15 minuti»[8]. Dunque: essi si limitano a registrare le azioni osservate su una scheda (scheda SGCC) e verificano la conformità ad un protocollo. L’”unità temporale” di osservazione, ripetuta in tre momenti diversi (due ore di italiano e di matematica) è a sua volta scomposta in sottomultipli orari di 15 minuti ciascuno. Sulla base di una variabile dicotomica (SI/NO) l’osservatore segnala la presenza dei comportamenti adeguati, ogni quarto d’ora. Ovviamente, è necessaria concordanza tra le osservazioni dei due valutatori esterni. Se il dato comportamento è osservato da uno solo dei due elementi esterni, l’item non viene “spuntato”. Occorre poi valutare con che frequenza si manifesta il grado di concordanza, nonché fare una sintesi dei tre differenti momenti di osservazione impiegati.

Riportiamo pochi dettagli “tecnici”, non per entrare nel merito di questa o quella modalità statistica, del tipo di modello matematico impiegato, ma per evidenziare il livello di “ingegnerizzazione” del metodo, a paragone con l’obiettivo prefissato, ossia valutare come si svolgono due ore di matematica o di italiano in una classe di bambini di 10 o 11 anni in una qualsiasi scuola del nostro paese.

Quali informazioni trarre dai risultati

Capiti contesto e modello, inquadrato il metodo di lavoro, emerge un’ulteriore perplessità.

Come è possibile che, conoscendo – presumibilmente – gli strumenti di valutazione, aderendo volontariamente al programma, concordando le osservazioni e le visite, gli insegnanti interessati abbiano potuto essere così poco strutturati nell’organizzazione delle loro lezioni? Non avere deliberatamente cura dei bisogni degli allievi più svantaggiati? Gestire con poca attenzione il clima della classe? Non restituire commenti, suggerimenti, stimoli ai ragazzi? Come possiamo spiegarci un atteggiamento così apertamente inerte per non dire scadente?

Per provare a rispondere all’interrogativo precedente, partiamo per gradi.

Diamo per scontato che:

il modello impiegato sia valido (la letteratura riportata dal progetto rappresenta un elemento probatorio in tal senso),

l’adesione sia stata realmente volontaria, anche da parte dei docenti e non solo dei dirigenti

gli insegnanti rientrino nella figura dell’insegnante medio (escludiamo quelle che gli statistici chiamano “code” della distribuzione).

Una lettura degli esiti del questionario di percezione degli insegnanti e del report finale sulla percezione studenti-docenti[9], permette di escludere l’ipotesi che i docenti fossero poco convinti e motivati, e che sul loro agire didattico siano intervenuti non ben precisati “fattori di disturbo” esterni e poco controllabili: «i dati mostrano che, nella maggioranza dei casi (90%) gli insegnanti dichiarano di essersi sentiti poco preoccupati prima della visita, a proprio agio durante l’osservazione in classe…La quasi totalità degli insegnanti dichiara di non essersi sentita né giudicata né influenzata nel proprio modo di condurre la lezione. Più in generale, l’osservazione in classe è stata vissuta come un’esperienza positiva..».

Dunque, ricapitolando: docenti collaborativi e volontari, a conoscenza del metodo di valutazione, a proprio agio nonostante gli osservatori, hanno “prodotto” risultati così poco soddisfacenti. A questo punto, le conclusioni sembrano essere due:

O gli insegnanti sono del tutto inadeguati, dunque esiste un problema di collocazione di questi insegnanti nelle classi e, ammettendo che essi siano un campione rappresentativo, di tutti gli insegnanti in tutte le classi d’Italia.

Oppure non c’è chiarezza e condivisione di definizione tra le variabili “misurate” (capacità didattica dell’insegnante) e syllabus impiegato (griglia di osservazione). In altre parole, si tratta di una riduzione e semplificazione eccessiva di un fenomeno complesso (di tipo psicologico o educativo) ad un modello matematico.

Sembra chiaro che i dati pubblicati dalla Fondazione, inducono, dopo una rapida osservazione, a propendere per la conclusione nr 1). Conclusione, a cui dovrebbe far seguito (come minimo) un comunicato stampa del MIUR e di INVALSI e a seguire una presa di posizione politica, data la gravità dei fatti.

Noi riteniamo, invece, che sia proprio la conclusione nr 2 a meritare un approfondimento.

L’uso di una serie di indicatori che stabiliscono la conoscenza di un fenomeno (in questo caso la lezione di italiano e matematica) non può avere la pretesa di essere oggettiva, “scientifica”. La definizione delle abilità da testare, degli items da spuntare, è delegata a chi prepara la griglia di valutazione: ossia a INVALSI e FGA. Dunque esiste un problema macroscopico di condivisione della scelta, di commensurabilità dei risultati tra elementi diversi, di oggettività scambiata per ragionevolezza e buon senso[10].

Nell’indagine si è fatto uso di modelli di valutazione stranieri, quasi tutti di matrice anglo-americana, destinati fatalmente a orientare la conclusione verso esiti predeterminati. Peraltro fortemente condizionati dall’incongruità tra le griglie utilizzate e l’oggetto cui vengono applicate. Preme sottolineare ancora una volta quest’aspetto per un doppio ordine di considerazioni: 1) si dà per scontato che la valutazione della scuola debba provenire da professionisti estranei all’attività docente e alla pratica didattica; 2) di conseguenza, il docente –forte di una preparazione professionale derivata da un iter formativo condizionato dalle specificità della disciplina insegnata- non potrà che trovarsi in difficoltà di fronte a un’indagine impostata secondo criteri elaborati al di fuori dell’esperienza scolastica.

Proviamo, per assurdo, a rovesciare la situazione: cosa otterremmo da un’indagine che misura la produttività di un ente finanziario, misurata con una griglia di valutazione costruita da insegnanti di italiano e latino, di matematica e fisica? Insegnanti che abbiano accumulato un dignitoso monte ore di formazione nel loro portfolio docente, per carità, che conoscano l’evoluzione dei differenziali di rendimento tra BTP e titoli di stato tedeschi, che sappiano calcolare indici di liquidità e redditività, ma pur sempre insegnanti di italiano e matematica.

Il richiamo al rigore scientifico che il corredo di modello e dati porta con sé, non è sovrapponibile al metodo scientifico, quello con cui solo la ricerca costruisce la conoscenza dei fenomeni. Ovvero una griglia, per quanto rigorosa, non potrà mai risultare efficace se applicata ad oggetti che non le corrispondono. Una misura scientifica, ad esempio in fisica, va condotta in ambiente artificiale e controllato (laboratorio). E’ proprio questa la rivoluzione del metodo scientifico. Considerare rigorosa l’osservazione di un fenomeno (modello di scienza aristotelica), tanto più se si tratta di un fatto educativo, significa dimenticare la realtà e la complessità del fenomeno stesso, l’ostacolo epistemologico implicito nell’impiego di misure indirette, di variabili latenti[11].

Discutibile risulta pure la convinzione che il sistema di valutazione adottato permetta di accertare la «lezione autentica». I dubbi, in questo caso, non dipendono solo dall’incongruità già ricordata tra sistema di valutazione e oggetto valutato, ma dallo stesso obiettivo ricercato. L’aggettivo «autentico», infatti, unito di volta in volta ai sostantivi «lezione» o «valutazione», è uno dei pilastri fondanti della cultura pedagogistica, pur conservando un’estrema ambiguità semantica. Si tratta, analogamente a quello di «competenza», di un concetto ad alto tasso ideologico che, coerentemente, evita il confronto critico innalzando in modo autoreferenziale i propri assunti a dignità scientifica. Il termine «autentico», infatti, per il suo carattere contrappositivo intende delegittimare la prassi consueta della professionalità docente, a favore di attività in linea con la didattica innovativa, le cui caratteristiche sono quelle indicate nel protocollo[12].

Nonostante questa lodevole intenzione, risulta però impossibile, attraverso una scheda o un modello matematico, far parlare e comunicare tra loro mondi diversi: quello delle organizzazioni e della produttività con quello della scuola e della formazione. Perché, per quanto “antiriformista” possa apparire, quello dell’insegnante è un mestiere. E non è affatto scientifico, ma “empirico”.

E’ un’impostura intellettuale pensare che 190 osservatori estranei al mondo della Scuola, possano entrare in 1600 classi, osservarle per 10 quarti d’ora consecutivi, spuntando caselle in tre diversi momenti dell’anno, raccogliere l’output e restituircelo sotto forma di grafici a barre. I risultati ottenuti non sono una conquista di ordine epistemologico acquisita dal mondo scientifico, ma una grande vittoria politica del mondo delle associazioni, tanto estranee alla scuola quanto vicine al mondo economico.

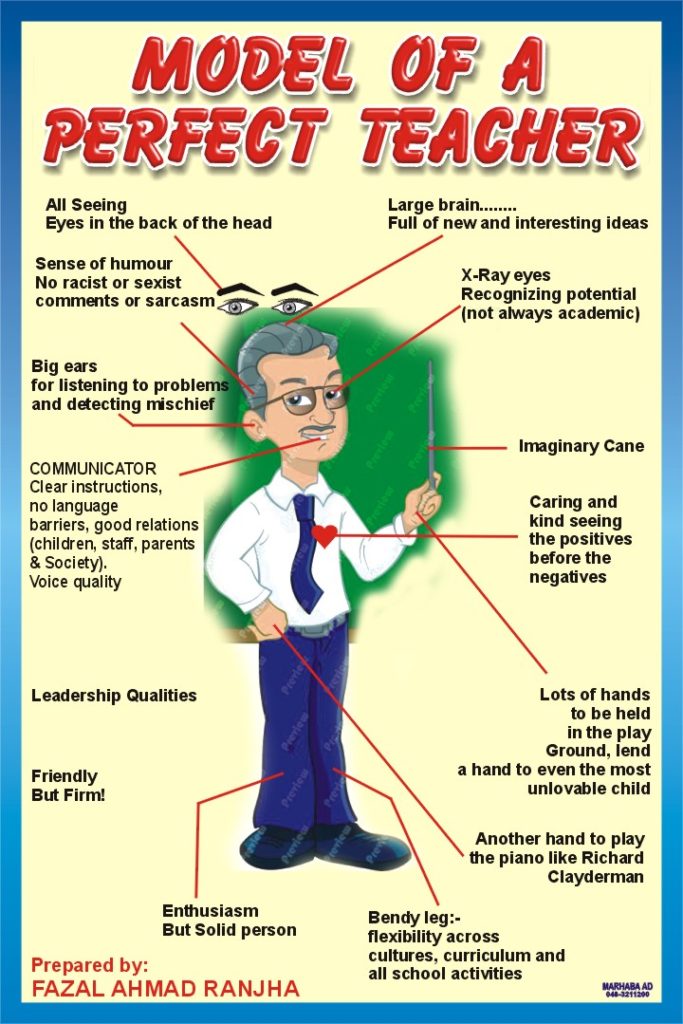

Non esistono “IL metodo di insegnamento”, “LA lezione perfetta o autentica”. Usare tecniche di narrazione, impiegare nuove tecnologie, strutturare al minuto la lezione o lasciare spazi all’improvvisazione – nata da bisogni reali e imprevedibili- lasciare libero dialogo o pretendere silenzio e rigore assoluti, sono tutti metodi di insegnamento possibili e validi. Lo sono in una classe e non in un’altra, in un certo momento e non in un altro. Gli alunni non possono essere motivati, attratti, coinvolti, impegnati a “imparare ad imparare” per 5 o 6 ore al giorno, 200 giorni all’anno, in circa 12 discipline. L’insegnante, d’altra parte, solo attraverso una continua riflessione su metodi e contenuti della propria disciplina, può rendere viva e significativa la conoscenza. Solo restando sé stesso e scegliendo liberamente (che non significa arbitrariamente) il proprio metodo di insegnamento, può insegnare agli allievi ad avere un rapporto libero con la cultura. ”E’ con l’esempio che si dimostra ai ragazzi ciò che è possibile anche per loro. L’insegnante è, solo se è libero”[13].

Autonomia scolastica significa scelte personali e soprattutto disciplinari, scelta di metodi e strumenti. Le coorti di “prove parallele”, uguali per tutte le discipline, che stanno via via scandendo la didattica di tutte le scuole italiane, non sono un caso, una scelta locale e dunque autonoma. Sono l’estremo tentativo di rispondere alla richiesta di efficienza che proviene dall’INVALSI[14]. Ma le “libertà collettive” o “libertà collegiali”, non esistono, sono proprie di sistemi iper-centralizzati.

Non sembra corrispondere a questi principi il metodo d’insegnamento auspicato dalla FGA, sostanzialmente obbligato, in base a presupposti le cui fondamenta epistemologiche risultano quanto meno dubbie. Tale pretesa va di pari passo con una critica costante tesa a delegittimare attività consolidate, quali la lezione frontale, rappresentata in modo per lo più caricaturale. Essa –è bene ribadirlo- rappresenta invece un presupposto irrinunciabile in una relazione asimmetrica quale rimane la trasmissione di sapere; proprio perché permette di valutare la metodologia opportuna da svolgersi di volta in volta, per sollecitare la motivazione, valutare la qualità e la frequenza degli interventi degli alunni, nonché le strategie opportune per intensificarli. Ovviamente, tale capacità osservativa e relazionale ha bisogno di tempi lunghi, nei quali è inevitabile affrontare situazioni sfidanti (la noia, un’iniziale passività), che in ogni caso contribuiscono alla crescita personale. La logica dei quindici minuti, individuati quale unità minima di valutazione nell’inchiesta della FGA, distruggerebbe invece la credibilità anche del migliore docente.

Non è un’idea né antiriformista né corporativa preservare la specificità della propria disciplina e il proprio stile di lavoro. Se è vero che gli allievi hanno diversi bisogni educativi e stili di apprendimento, hanno tutti la necessità di appropriarsi di una cultura e dei suoi strumenti. E se la società impone la verifica del lavoro svolto in nome di un principio di trasparenza, allora la valutazione deve essere materia di scuola, di disciplina, di contesto[15]. “Non esiste in astratto il «giusto» modello della valutazione: ciascun modello dipende da un’idea di scuola”, dicevamo. E non esiste in astratto il “giusto” modello di insegnante, aggiungiamo. Dipende dall’idea di scuola. Noi quale scuola vogliamo?

[1] http://www.fga.it/note-e-contributi/tutte-le-note/dettaglio/article/osservazioni-in-classe-620.html#.WUwP62gT600

[2] https://labuonascuola.gov.it/

[3] Quale dirigenza per la scuola dell’autonomia?, proposte per una professione nuova, Treelle, 2007.

[4] Espressione usata da Damien Lanfrey, uno degli ideatori del documento Piano della Nuova Scuola Digitale, http://damienlanfrey.nova100.ilsole24ore.com/2015/10/30/abbiamo-un-piano-e-digitale/. Sul curriculum vitae di Damien Lanfrey e degli altri collaboratori del ministro, in relazione alle loro competenze per intervenire nel dibattito sulla scuola cfr. al seguente link http://docplayer.it/271107-L-illusione-di-far-bene.html.

[5] Uno degli indicatori del recente rapporto di autovalutazione (RAV) con cui ogni scuola deve misurarsi, dal 2014 è proprio la “presenza di didattica innovativa”, non specificata, da attestare all’interno di una rubrica di valutazione graduata dall’1 (minimo) al 7 (eccellenza), da cui si evince che per “didattica innovativa” il MIUR considera “lavori di gruppo, utilizzo di nuove tecnologie, realizzazione di ricerche o progetti come attività ordinarie della classe”.

[6] FGA, Rapporto sulla valutazione nelle scuola, 2014 (vedi nota 3)

[7] Seminario informativo tenutosi a Formia, aprile 2015 (materiali sul sito INVALSI).

[8] Di documenti riportati nel sito del progetto: http://www.invalsi.it/Invalsi/ri/audit/doc_VM.php.

[9] Entrambi i documenti sono riportati nel sito del progetto (vedi nota precedente).

[10] Nella lettera indirizzata al presidente dell’OCSE-PISA Andreas Schleicher, da numerosi intellettuali e scienziati, pubblicata in italiano al seguente link https://blogletteraturacapuana.wordpress.com/2014/05/15/traduzione-in-italiano-della-lettera-aperta-a-andreasschleicher-ocse-parigi/ , viene contestata la legittimità dei criteri di valutazione adottati, anche denunciando l’interesse di determinati settori economici a condizionarli: ««Al momento, infatti, coloro i quali esercitano maggiore influenza sulle scelte valutative dei livelli di apprendimento dell’istruzione globale sono esperti di psicometrica, di statistica e di economia. […] sarebbe opportuno, dunque, far partecipare al tavolo delle decisioni circa i metodi e gli standard di valutazione degli apprendimenti anche organizzazioni internazionali che hanno a cuore, non esclusivamente gli aspetti economici, ma anche la salute, lo sviluppo personale, il benessere di studenti e docenti».

[11] E. Rogora, intervento in dibattito sulle rilevazioni INVALSI, Università di Roma, 2013 (reperibile online).

[12] Il concetto di «autentico» in pedagogia è anch’esso di origine anglofona. Si veda in proposito G.Wiggins, A TRìrue Test: Toward More Authentic and Equitable Assesment, in The Phi Delta Kappan, vol.70, Maggio 1989, pp.703-713, leggibile al seguente link: https://grantwiggins.files.wordpress.com/2014/01/wiggins-atruetest-kappan89.pdf. Per quanto riguarda la sua diffusione in Italia, cfr. M.Comoglio, La valutazione autentica, in Orientamenti pedagogici, 49 (1), 2002, pp.93-112, in cui appare il forte legame con la didattica per competenze. Tale concetto, tutt’altro che condiviso tra gli insegnanti, e segnato da evidenti aporie, è stato considerato dal MIUR un requisito indispensabile per i nuovi insegnanti, tanto da rientrare tra gli argomenti in programma per i recenti concorsi. A questo proposito, è utile la lettura del seguente documento: http://www.notiziedellascuola.it/legislazione-e-dottrina/indice-cronologico/2016/febbraio/DECRETO_MIUR_20160223_prot95/allinone_view

[13] L.Varaldo, La scuola rovesciata, ETS edizioni, 2016.

[14] Nel format del RAV, (nota 5), un indicatore precostituito è “presenza di prove parallele in ingresso, intermedie, di uscita”.

[15] Un’idea di valutazione è proposta nella Legge di Iniziativa Popolare sulla scuola, ripresa quest’anno, sulla base di una proposta passata: http://lipscuola.it/blog/per-la-scuola-della-costituzione-legge-di-iniziativa-popolare/

Co.bas. Scuola

Via Monsignor Fortin 44 – Padova

Email: [email protected]

Per urgenze chiamare il 347 9901965 (Carlo)

I comitati di base della scuola sono un sindacato di base nato negli anni ’80 e che da allora opera nel nostro territorio e nel territorio nazionale, con docenti e A.T.A. volontari – precari e non – disposti a mettersi in gioco.